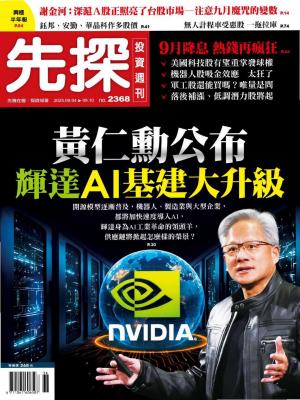

Nvidia這次公布的財報雖未帶來驚艷,卻不擔心長期發展。總能給全村希望的Nvidia,發布未來三年產品藍圖,從AI晶片供應商轉型為大型AI基礎平台架構供應商,若能達成目標,AMD、博通可能就更難與其相抗衡。 文●魏聖峰

全球資本市值最高企業的布財報顯示,即使財報內容與對本Nvidia最新公季的財測均優於市場預期,卻因為資料中心部門營收連續兩季呈現季減,財報內容並非無懈可擊;加上市場最近擔心AI泡沫化,以及Nvidia目前的高本益比壓力,造成公布財報後股價下跌。短線股價可能進入震盪整理,長線上AI霸主的地位尚無人可以挑戰。日前Nvidia舉行一場亞太媒體分享會,揭櫫未來三年藍圖計畫,一旦成形會讓Nvidia轉型為AI基礎設施架構的設計者。 從第二季四大CSP服務商發布的財報中,光是四大CSP今年的資本支出就會達到三三八○億美元,這些資本支出絕大部分都與AI相關,也有很大的部分都流向Nvidia。當前高階AI晶片市場僅Nvidia和超微,而Nvidia的市占率超過九成。但從Blackwell架構開始,Nvidia向客戶提供的高階AI晶片已經不再是單從的系統單晶片,而是一個機櫃。機櫃內容包含HBM、高階CCL、液冷系統以及電源備援系統(BBU)等零組件。對客戶來說,機櫃內容可以客製化,機櫃出貨給客戶後,安裝容易。

全球資本市值最高企業的布財報顯示,即使財報內容與對本Nvidia最新公季的財測均優於市場預期,卻因為資料中心部門營收連續兩季呈現季減,財報內容並非無懈可擊;加上市場最近擔心AI泡沫化,以及Nvidia目前的高本益比壓力,造成公布財報後股價下跌。短線股價可能進入震盪整理,長線上AI霸主的地位尚無人可以挑戰。日前Nvidia舉行一場亞太媒體分享會,揭櫫未來三年藍圖計畫,一旦成形會讓Nvidia轉型為AI基礎設施架構的設計者。 從第二季四大CSP服務商發布的財報中,光是四大CSP今年的資本支出就會達到三三八○億美元,這些資本支出絕大部分都與AI相關,也有很大的部分都流向Nvidia。當前高階AI晶片市場僅Nvidia和超微,而Nvidia的市占率超過九成。但從Blackwell架構開始,Nvidia向客戶提供的高階AI晶片已經不再是單從的系統單晶片,而是一個機櫃。機櫃內容包含HBM、高階CCL、液冷系統以及電源備援系統(BBU)等零組件。對客戶來說,機櫃內容可以客製化,機櫃出貨給客戶後,安裝容易。

新架構藍圖顯現企圖心 Nvidia在八月二十二日舉行一場亞太媒體分享會中揭櫫該公司未來三年的產品藍圖計畫,將陸續推出的GPU架構將從目前的Blackwell演進到Rubin、Feynman。將從現有單一AI機櫃伺服器走向多資料中心串連在一起的超級運算中心架構。目前建構AI資料中心基礎設施連結主要有,垂直擴展(ScaleUp)和水平擴展(Scale-Out),未來將會變成由數個資料中心互聯的Scale-Across,形成一個跨區的超級運算中心體系。以因應AI模型規模變大後,動輒數百兆個Token在幾秒內快速傳輸,單一資料中心難以負荷如此量大的傳輸。還有機房空間不足的問題也需要分散部署,必須建構成跨資料中心的連結才能在最短時間內完成最大的工作量。若能達成上述目標,Nvidia將從AI晶片設計公司轉型為AI基礎架構平台服務商,目的是要讓AI資料中心都能在由Nvidia提供的基礎架構平台上,使得Nvidia在未來的AI產業發展中變成不可或缺的元素。 多個資料中心光學互聯 從NvidiaGPU未來三年路線圖來看,屬於單一機櫃的Blackwell架構內涵HBM3e記憶體,採用GraceCPU和NVLink交換器。在這個機櫃中,在空間內儘量增加CPU和GPU資源,採用垂直連結。在二六年要推出的Rubin架構中,記憶體提升到HBM4,使AI推理效能更高。在Rubin架構中,在單一資料中心內將由多個機櫃組成,屬於多台伺服器集群,採用水平擴展的連結模式。Rubin架構內,CPU提升到VeraCPU、交換器提升到Spectrum-X,會比Blackwell晶片效能提升兩唄。由於有多個伺服器集群,將會使開始用到矽光子技術(CPO),取代傳統銅線傳輸。CPO技術有更大頻寬、低延遲等特性,雖然價格不斐,客戶長期使用下來,能在高倍速運算能達到降低成本目的。 在二八年的Feynman架構,會有多個資料中心的連結技術,記憶體採用HBM4e,會比Rubin架構的AI推理能力至少增加數倍,CPU至少也是VeraCPU等級。該架構的交換器會提升到Spectrum-XGS。XGS代表的是Gigascale,專門為大規模資料中心所設計的高倍速交換器,也是採用CPO技術的光學互聯。Feynman架構中,不僅在單一資料中心內互聯,還要達到多個資料中心互聯的目的。其所採用的連結技術是Scale-Across,Nvidia將透過新一代乙太網路技術,把數個分散式資料中心,組合成一座超級運算中心。

閱讀完整內容